- Android Speech to Text Tutorial

- Управление голосом в приложениях на Android

- Обработка речи в Android

- Обзор системы обработки речи

- Requirements (Требования)

- Разница между пониманием и преобразованием

- Настройка

- Создание намерения

- Преобразование речи

- Преобразование текста в речь

- Шаг 1. Создание экземпляра TextToSpeech

- Шаг 2. Поиск доступных языков

- Шаг 3. Настройка скорости и тона речи

- Шаг 4. Проверка и скачивание новых языков

- Шаг 5. IOnInitListener

- Сводка

Android Speech to Text Tutorial

In this article, we will learn how to implement speech to text functionality in android. To enable our app to use speech to text we have to use the SpeechRecognizer class.

Let’s see what is written in the official documentation:

This class provides access to the speech recognition service. This service allows access to the speech recognizer. Do not instantiate this class directly, instead, call SpeechRecognizer#createSpeechRecognizer(Context) . This class’s methods must be invoked only from the main application thread.

The implementation of this API is likely to stream audio to remote servers to perform speech recognition. As such this API is not intended to be used for continuous recognition, which would consume a significant amount of battery and bandwidth.

Let’s implement this to understand it better.

First of all, create a new Android Studio project and in the manifest file add the following user-permissions:

Now in the activity_main.xml file, we will add an EditText and an ImageView.I will not explain the layout file as I don’t want to waste anybody’s time who is here to learn the Speech to Text.You can see the code below.

Let’s dive into the MainActivity.java file.

First, we will check for the permissions:

If the permission is not granted then we will call the checkPermission method.

Now here comes the important part first which will initialize the SpeecRecognizer object and then create the intent for recognizing the speech.

As you can see we have added some extras let me explain what are they.

The constant ACTION_RECOGNIZE_SPEECH starts an activity that will prompt the user for speech and send it through a speech recognizer.

EXTRA_LANGUAGE_MODEL: Informs the recognizer which speech model to prefer when performing ACTION_RECOGNIZE_SPEECH.

LANGUAGE_MODEL_FREE_FORM: Use a language model based on free-form speech recognition.

EXTRA_LANGUAGE : Optional IETF language tag (as defined by BCP 47), for example, “en-US”.

Now we will set a speechRecognitionListener to our speechRecognizer object using the setRecognitionListener() method.

You can see after setting the listener we get several methods to implement. We will go the onResults method and add the following code

We get an ArrayList of String as a result and we use this ArrayList to update the UI (EditText here).

Build better voice apps. Get more articles & interviews from voice technology experts at voicetechpodcast.com

In the onBeginningOfSpeeh() method we will add the following code to tell the user that his voice is being recognized.

Now, lets set up the imageView. We will add a touchListener to the image view to know when the user has pressed the image.

When the user taps the imageView the listener starts listening and the imageView source image is also changed to update the user that his voice is being listened to.

You can find the full source code below:

Let’s run the app.

Now you are capable of adding a cool functionality to your app. What are you waiting for start coding…

You can get the full source code from my GitHub.

Источник

Управление голосом в приложениях на Android

Началось все с того, что я посмотрел неплохой обзор (сравнение) Siri и Google Now. Кто из них лучше, спорить не буду, однако у меня лично планшет на Андроиде. Я подумал, а что если написать калькулятор полностью на голосовом управлении (удобно ли будет?). Но для начала пришлось немного разобраться с самим голосовым управление, точнее говоря с голосовым вводом (управления еще добиться надо). Кроме того, я только что скачал Android Studio, и мне не терпелось скорей опробовать ее на практике (ну на минипроекте). Что ж, начнем.

Кидаем на активность ListView и Button. В ЛистВью будем сохранять сами команды, точнее варианты одной команды, а кнопка будет вежливо спрашивать, чего мы желаем. Да, программа логикой не будет обладать, с ее помощью просто посмотрим саму реализацию.

Добавим так же в Манифест одно разрешение

И все, теперь можно переходить непосредственно к программированию. «Находим необходимые компоненты»:

Прописываем обработчик нажатия для кнопки, который вызовет метод startSpeak(), о котором мы поговорим далее:

Ну наконец закончилась «вода». Начинаем «говорить»:

Пришло время дать волю фантазии и решить какие команды использовать. Сам я сначала хотел показать на примере тетрисного танчика: диктовали бы ему «up», «down», «left», «fire» и так далее, но это сложно оставляю вам. Я же отдавал команды по смене цвета кнопки, выходу из приложения, открытию страниц в браузере, запуску карт и перезагрузке устройства. Что касается последнего, reboot, это команда будет работать, как я понял, только на рутованных устройствах. На телефоне у меня есть права СП и все хорошо работает, а вот на планшете, он просто игнорирует эту команду. В записи команд нет ничего сложного, думаю комментариев будет достаточно:

Так выглядит окно записи команд:

Скажем с красивым английским акцентом «maps». Вызвали Google Maps:

Как видите, в списке выводятся все возможные (похожие) слова и из них уже выбирается необходимое нам.

Ну и на «finish», я закончил беседу с бездушной (или нет?) машиной.

Надеюсь моя небольшая статья побудит кого-нибудь на создание (не, не терминатора) какого-либо перспективного проекта, который упростит повседневную жизнь людям, а вам принесет миллионы, ну или хотя бы окажется полезной. Дерзайте!

Источник

Обработка речи в Android

В этой статье рассматриваются принципы работы с мощным пространством имен Android.Speech. С момента своего создания платформа Android умеет распознавать речь и выводить ее в виде текста. Этот процесс относительно прост. Но обратное преобразование текста в речь влечет больше сложностей, так как в нем нужно учитывать не только подсистему обработки речи, но и доступные языки, установленные из системы преобразования текста в речь (TTS).

Обзор системы обработки речи

Наличие системы, которая «понимает» человеческий голос и проговаривает вводимые данные (преобразование речи в текст и текста в речь) — это активно развивающееся направление в разработке мобильных приложений, так как потребность в естественном взаимодействии с устройствами постоянно растет. Существует множество ситуаций, в которых функция преобразования текста в речь или речи в текст станет очень полезным инструментом для внедрения в приложение для Android.

Например, после запрета использования мобильных телефонов за рулем пользователи ищут способы управлять устройствами без использования рук. Множество разных форм-факторов устройств Android, включая Android Wear, и постоянно растущее разнообразие устройств с Android (например, планшеты и блокноты) создают значительный интерес к хорошим приложениям с системой TTS.

Google предоставляет разработчикам через пространство имен Android.Speech богатый набор API-интерфейсов, которые позволяют устройствам «понимать речь» в большинстве сценариев (например, программное обеспечение для слепых людей). Это пространство имен содержит возможности для преобразования текста в речь через Android.Speech.Tts и управления подсистемой преобразования, а также несколько классов RecognizerIntent для обратного преобразования речи в текст.

Но даже при наличии возможностей для работы с речью нельзя забывать об аппаратных ограничениях. Не стоит ожидать, что устройство сможет успешно интерпретировать любую речь на любом из существующих языков.

Requirements (Требования)

Для работы с этим руководством нет особых требований. Вам потребуется только устройство с микрофоном и динамиком.

Основной системы интерпретации речи на устройствах Android является метод Intent с соответствующим объектом OnActivityResult . Но здесь важно понимать, что этот процесс не подразумевает понимание речи, а только преобразование речи в текст. Это очень важное различие.

Разница между пониманием и преобразованием

Если по-простому, то понимание — это возможность понять реальное значение сказанного с учетом тона и контекста. Преобразование же сводится к выделению слов и выводу их в другой форме.

Рассмотрим простой пример из нашей ежедневной жизни.

Привет! Как дела?

Без выделения интонацией отдельных слов или их частей это будет простой вопрос. Но если произнести эту фразу медленно, человек быстро почувствует, что спрашивающий находится в плохом расположении духа, нуждается в поддержке или даже болен. Если слово «дела» выделяется интонационно, это обычно означает более высокую заинтересованность в ответе.

Без довольно мощных возможностей обработки звука, позволяющих анализировать интонацию, и искусственного интеллекта для анализа контекста программное обеспечение даже не приблизится к пониманию смысла — обычный смартфон может лишь преобразовать речь в текст.

Настройка

Перед началом работы проверьте наличие микрофона на устройстве. Нет никакого смысла запускать приложение на устройстве Kindle или Google, на котором нет микрофона.

Следующий пример кода демонстрирует запрос, который проверяет наличие микрофона и, если микрофона нет, создает предупреждение. Если микрофон на этом этапе не обнаружен, вы можете завершить текущее действие или отключить функцию записи речи.

Создание намерения

Система обработки речи использует определенный тип намерения, которое называется RecognizerIntent . Это намерение управляет большим числом параметров, в том числе временем ожидания в тишине до завершения записи, возможностью распознавать и выводить текст на других языках, выводом дополнительных инструкций в модальном диалоге Intent и т. д. В этом фрагменте кода VOICE представляет собой намерение readonly int , которое используется в OnActivityResult для распознавания речи.

Преобразование речи

Текст, полученный на основе речи, предоставляется в намерение Intent , которое возвращается после завершения действия, а доступ к нему осуществляется через GetStringArrayListExtra(RecognizerIntent.ExtraResults) . Здесь возвращается список IList , для которого можно применять и отображать индекс в зависимости от числа языков, запрошенных в вызове намерения (и указанных в RecognizerIntent.ExtraMaxResults ). Но как и с любым другим списком, есть смысл проверить наличие данных для отображения.

При ожидании возвращаемого значения StartActivityForResult нужно предоставить метод OnActivityResult .

В следующем примере textBox представляет собой TextBox для вывода диктуемого текста. Его можно с тем же успехом применять для передачи текста в какое-то средство интерпретации, а полученные результаты сравнить с примерами текста и передать в другую часть приложения.

Преобразование текста в речь

Преобразование текста в речь нельзя рассматривать просто как обратную функцию к преобразованию речи в текст, так как эта функция зависит от двух важнейших компонентов: установленной на устройстве подсистемы преобразования и установленного в системе языка.

В основном устройства Android поставляются с установленной стандартной службой TTS от Google и хотя бы одним языком. Эти параметры определяются при первой настройке устройства и зависят от текущего расположения устройства на тот момент (например, для настраиваемого в Германии телефона будет установлен немецкий язык, а в США — американский английский).

Шаг 1. Создание экземпляра TextToSpeech

TextToSpeech принимает до трех параметров, AppContext , IOnInitListener и engine , из которых первые два — обязательные. Прослушиватель (listener) используется для привязки к службе и проверки на наличие ошибок, а подсистемой (engine) может быть любое число доступных служб Android подсистем преобразования текста в речь. Как минимум, на устройстве будет подсистема от Google.

Шаг 2. Поиск доступных языков

Класс Java.Util.Locale содержит полезный метод с именем GetAvailableLocales() . Теперь можно сопоставить список языков, поддерживаемых подсистемой обработки речи, и языков, установленных в системе.

Из них очевидным образом выводится список «понимаемых» языков. В этом списке всегда будет присутствовать язык по умолчанию (тот, на котором пользователь впервые настраивал это устройство). Таким образом в нашем примере для List первым параметром указывается значение Default, а остальные элементы списка заполняются по результатам выполнения textToSpeech.IsLanguageAvailable(locale) .

Этот код вызывает TextToSpeech.IsLanguageAvailable, чтобы проверить наличие на устройстве языкового пакета для определенного языкового стандарта. Этот метод возвращает LanguageAvailableResult, что позволяет определить, есть ли в системе язык для полученного языкового стандарта. Если LanguageAvailableResult имеет значение NotSupported , это означает, что для этого языка нет доступного (даже для скачивания) голосового пакета. Если LanguageAvailableResult имеет значение MissingData , это означает, что можно скачать новый языковой пакет (см. шаг 4).

Шаг 3. Настройка скорости и тона речи

Android позволяет пользователям изменять звучание речи через параметры SpeechRate и Pitch (скорость и тон речи соответственно). Эти параметры принимают значения от 0 до 1, где «обычной» речи соответствует значение 1.

Шаг 4. Проверка и скачивание новых языков

Для скачивания нового языка используется намерение Intent . Результат этого намерения приводит к вызову метода OnActivityResult. В отличие от примера «речь-к тексту» (который использовал рекогнизеринтент в качестве параметра Intent ), тестирование и загрузка Intent Action основаны на:

Тексттоспич. Engine. актиончеккттсдата — запускает действие из подсистемы платформы для проверки правильности установки и доступности языковых ресурсов на устройстве.

Тексттоспич. Engine. актионинсталлттсдата — запускает действие, предлагающее пользователю загрузить необходимые языки.

Следующий пример кода демонстрирует применение этих действий для языковых ресурсов и для скачивания нового языка.

TextToSpeech.Engine.ActionCheckTtsData проверяет доступность языковых ресурсов. После завершения этой проверки вызывается OnActivityResult . Если нужно скачать языковые ресурсы, OnActivityResult запускает действие TextToSpeech.Engine.ActionInstallTtsData , которое позволит пользователю скачать нужные языки. Обратите внимание, что реализация OnActivityResult не проверяет код Result , поскольку в нашем упрощенном примере решение о необходимости скачать языковой пакет уже принято.

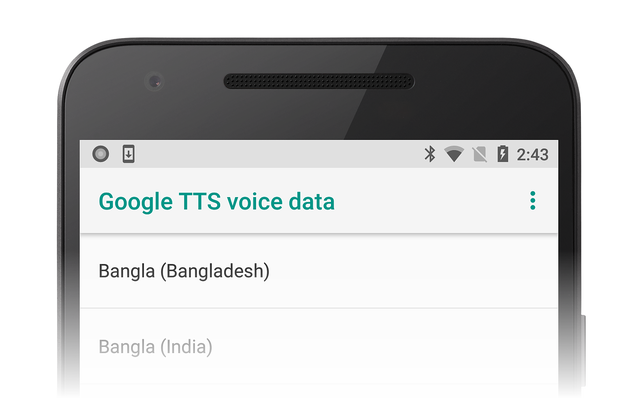

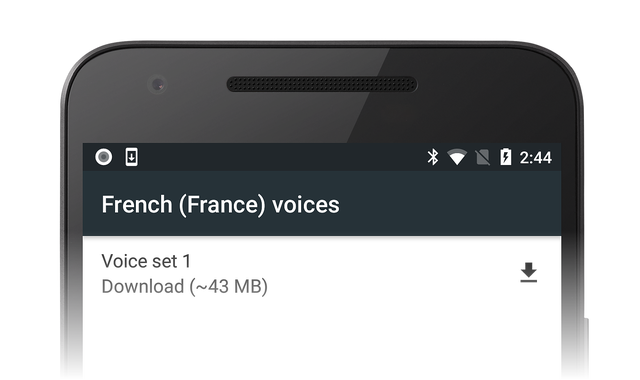

Это TextToSpeech.Engine.ActionInstallTtsData действие приводит к тому, что пользователю будет предоставлено действие по TextToSpeech.Engine.ActionInstallTtsData для выбора языков для загрузки:

Предположим, что пользователь выбрал французский язык и щелкнул значок скачивания, чтобы получить голосовые данные для французского языка.

После завершения скачивания данные будут установлены автоматически.

Шаг 5. IOnInitListener

Чтобы действие могло преобразовать текст в речь, нужно реализовать метод интерфейса OnInit (это второй параметр, который указывается для создания экземпляра класса TextToSpeech ). Он инициализирует прослушиватель и проверяет результат.

Прослушиватель должен проверять по меньшей мере OperationResult.Success и OperationResult.Failure . В примере ниже именно это и показано.

Сводка

В этом руководстве мы рассмотрели основные моменты преобразование текста в речь и речи в текст, а также возможные методы добавления этих технологий в приложения. Хотя мы и не охватили все возможные ситуации, у вас уже есть базовое представление о механизмах интерпретации речи, установке новых языков и повышении инклюзивности приложений.

Источник