- Как включить функцию Deep Fusion на iPhone 11, iPhone 12 и старых iPhone

- Что такое Deep Fusion?

- Как включить Deep Fusion на iPhone 11 и iPhone 12

- На каких iPhone есть Deep Fusion?

- Проверили, как работает Deep Fusion в новых iPhone

- Магия Deep Fusion от Apple: Что это на самом деле?

- Как работает?

- ЭТАП 1

- ЭТАП 2

- ЭТАП 3

- ЭТАП 4

- Как работает технология сверхчетких фото Deep Fusion в iPhone 11. Примеры

- Примеры фото

- Что в итоге

- Как включить функцию Deep Fusion из iOS 13.2 на старых iPhone

- Что такое Deep Fusion

- Как сделать фотографию лучше

Как включить функцию Deep Fusion на iPhone 11, iPhone 12 и старых iPhone

Вместе с iPhone 11 Apple представила технологию съёмки Deep Fusion с использованием искусственного интеллекта и нейронных сетей для получения на выходе максимально качественной фотографии. Технологию даже успели прозвать «режимом для свитера», так как Deep Fusion лучше всего справляется с обработкой мелких деталей. И хотя много где можно встретить информацию, что эта функция включена на новых iPhone по умолчанию, зачастую ее необходимо активировать вручную в настройках. Ниже расскажу, как это сделать.

Хотите делать фото с максимальными деталями? Deep Fusion поможет

Что такое Deep Fusion?

При съемке Deep Fusion задействует сразу несколько инструментов. Технология анализирует каждый пиксель и улучшает его, получая на выходе максимально бесшумный и максимально чёткий снимок без засветов и тёмных зон. Также она делает три снимка с короткой выдержкой до нажатия на кнопку спуска затвора, а потом ещё четыре, один из которых — на длинной выдержке. Потом все эти кадры объединяются в один и достигается более высокий уровень детализации кадра. Вместе с попиксельной обработкой снимка на выходе получается действительно сочное фото.

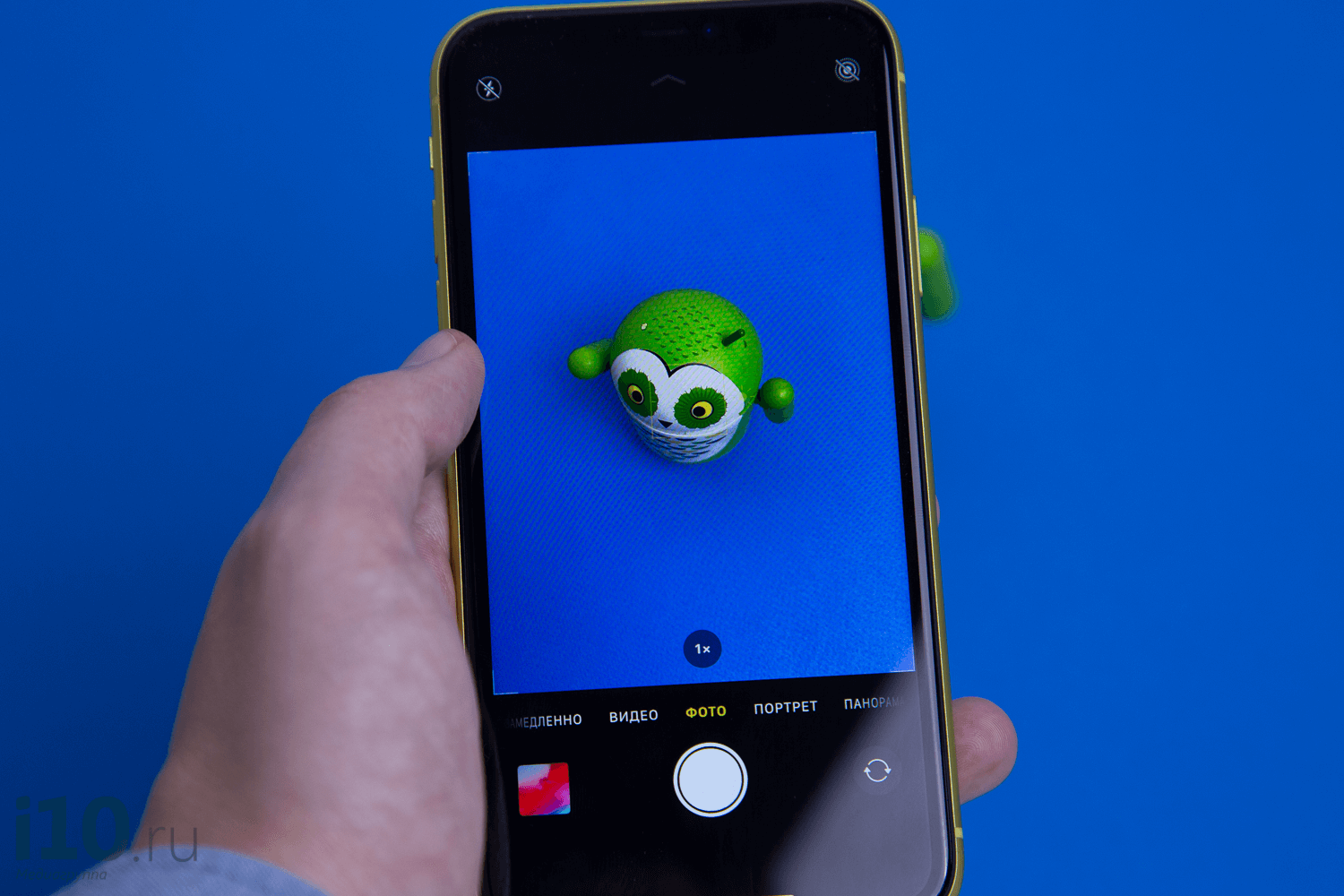

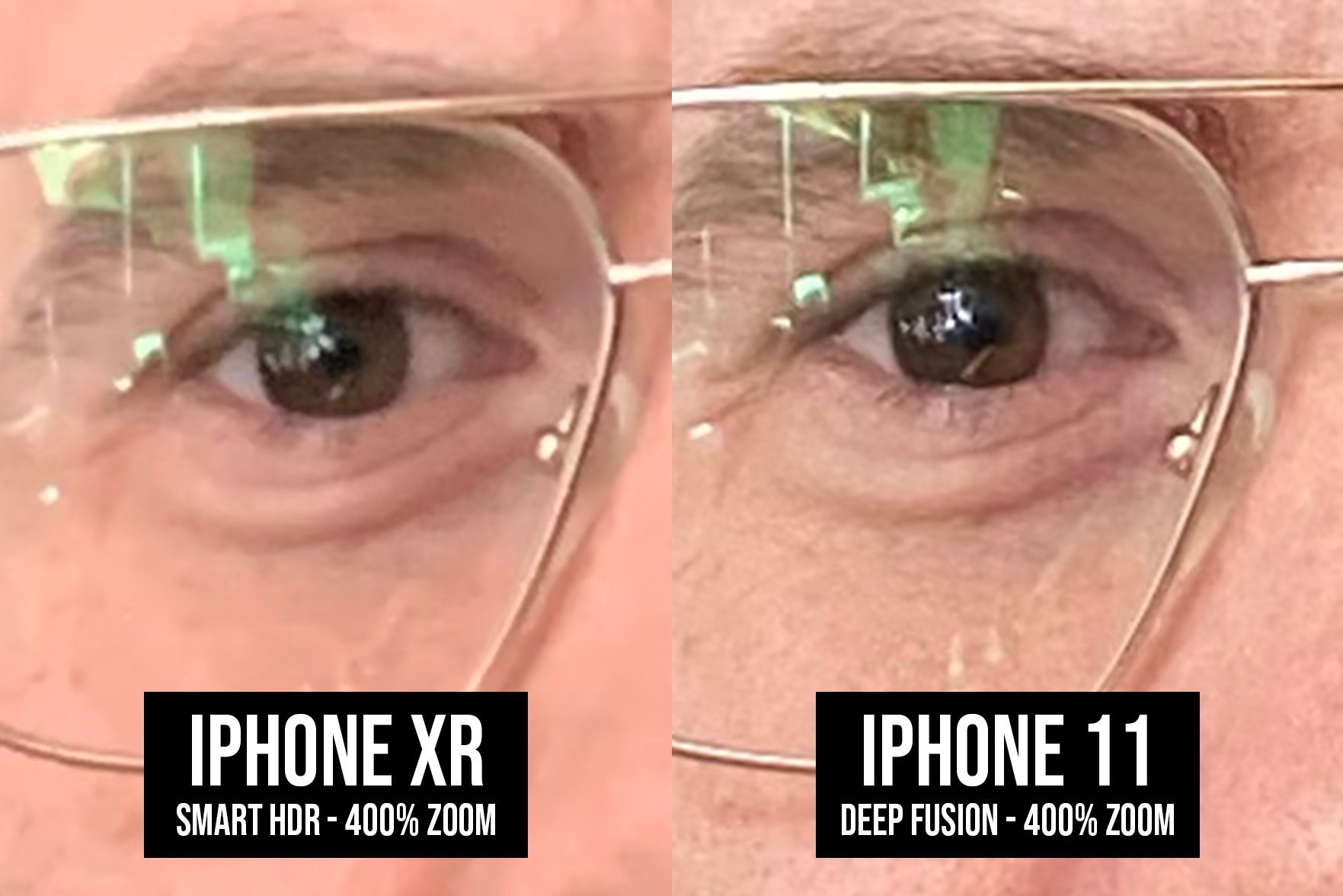

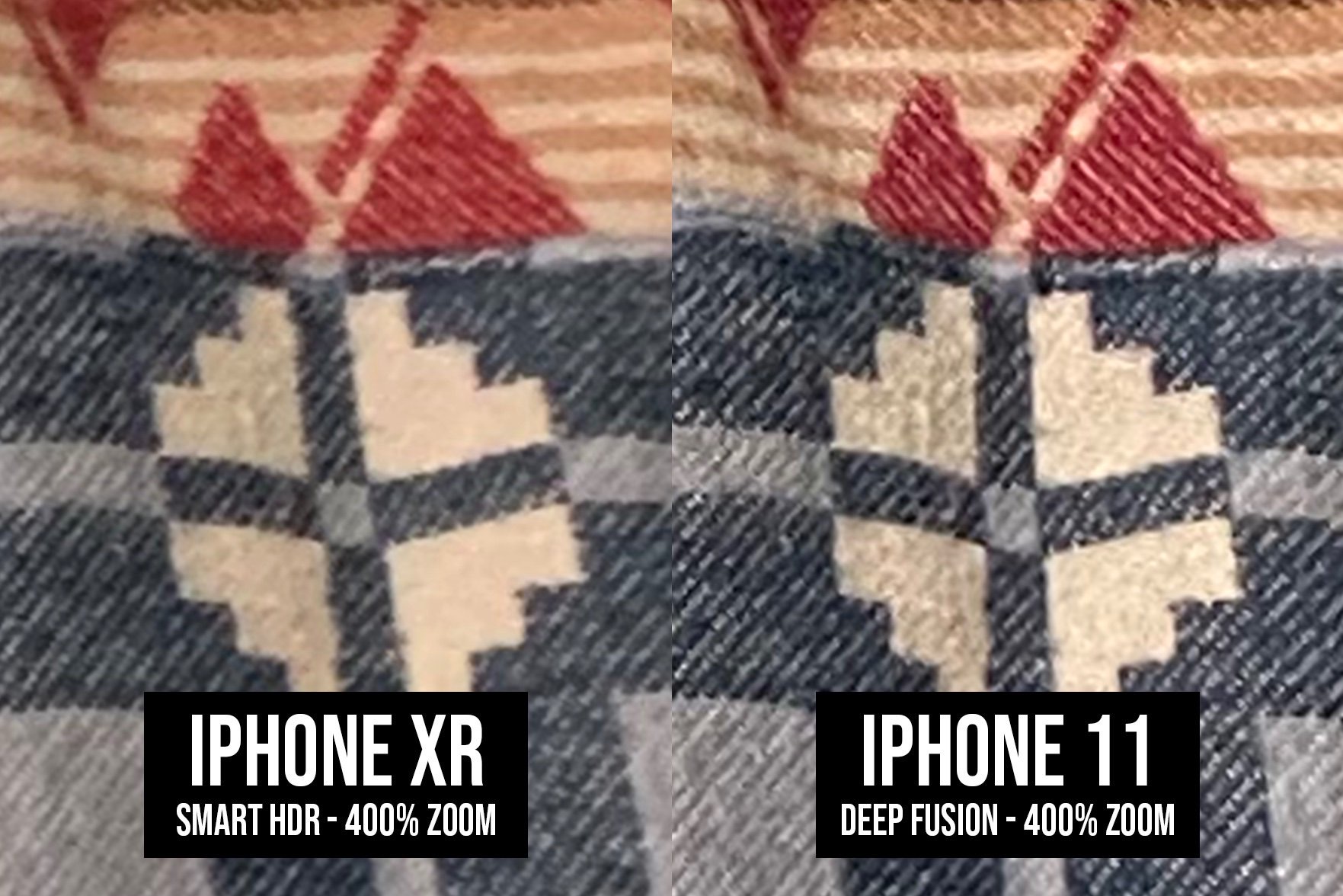

Вот парочка примеров (да, героев специально попросили надеть свитер тонкой вязки):

Как работает Deep Fusion

Deep Fusion хорошо справляется с мелкими деталями

Как включить Deep Fusion на iPhone 11 и iPhone 12

Deep Fusion действительно в большинстве случаев включается автоматически, но этот режим активируется только в определенных случаях. В первую очередь у вас должна быть установлена iOS 13.2 и новее. После этого проверьте следующие настройки:

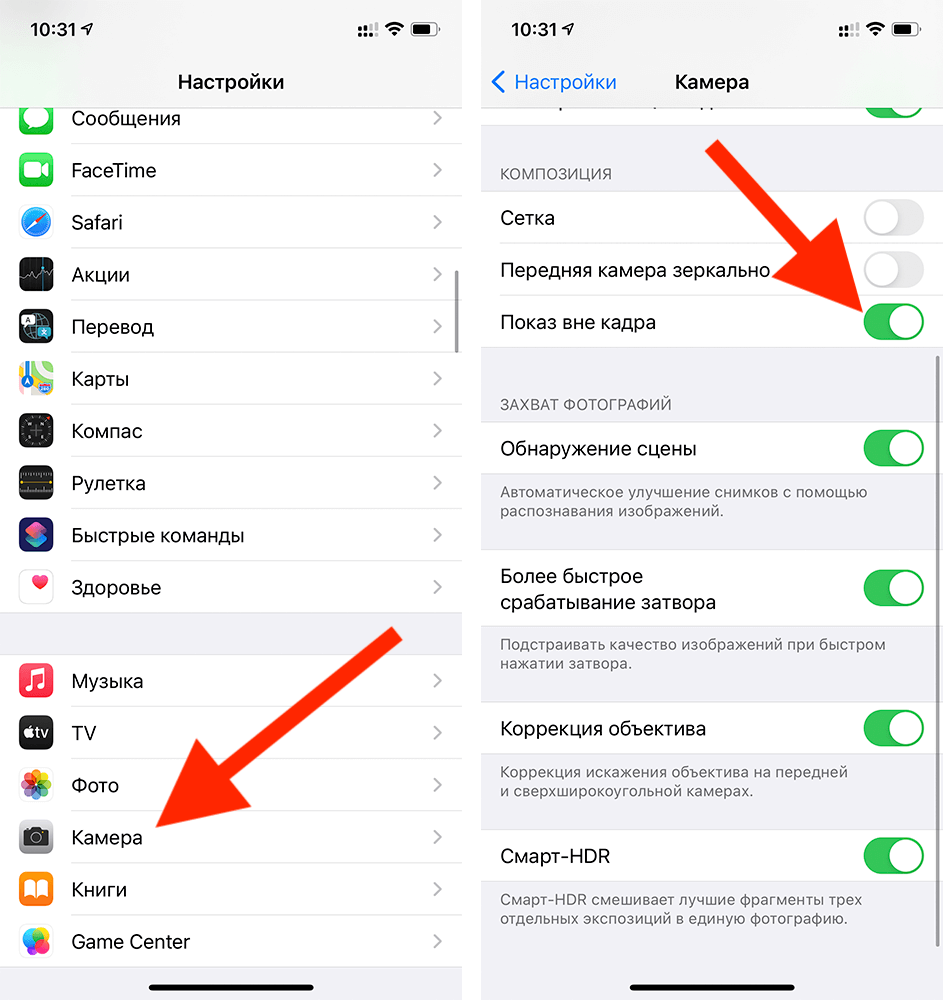

- Откройте Настройки на iPhone;

- Пролистайте до меню Камера и откройте его;

- В открывшемся меню в разделе Композиция выключите функцию Показ вне кадра.

Отключите эту функцию для работы Deep Fusion

После этого Deep Fusion будет срабатывать в автоматическом режиме. Хотя индикатор, указывающий на активную работу Deep Fusion не появится, вы однозначно заметите улучшенное качество фотографий.

Зачем отключать функцию Показ вне кадра? Она используется для захвата остальной части сцены за пределами кадра, однако Deep Fusion не может работать в таком режиме из-за недостатка пикселей фокусировки и оптической стабилизации изображения. Поэтому если вы оставите Показ вне кадра включенным, Deep Fusion работать не будет.

На каких iPhone есть Deep Fusion?

Поддержка технологии Deep Fusion на данный момент предусмотрена в iPhone 11, 11 Pro, 11 Pro Max и новее. Главное, чтобы в телефоне был 8-ядерный нейронный движок, установленный в процессор A13 и A14.

Однако включить функцию Deep Fusion можно и на старых iPhone с помощью сторонних приложений. Например, в популярном приложении камеры Halide также есть режим обработки фото с искусственным интеллектом (Smartest Processing), просто в этом случае используются алгоритмы не Apple, а стороннего разработчика. Они работают не так эффективно, но все же неплохо, учитывая, что других вариантов улучшить камеру айфона по сути нет. В нашем канале Яндекс.Дзен мы рассказывали об этом более подробно.

Преимущество Smartest Processing в том, что данная функция может улучшать как обычные фотографии, так и портретные снимки, и даже ночные. Тогда как Deep Fusion обычно работает хорошо только в условиях с хорошим освещением.

А как вы фотографируете на iPhone? Используете ли вы сторонние приложения вроде Halide или какие-то встроенные функции iOS? Расскажите в комментариях или можете даже отправить примеры фотографий в наш Телеграм-чат.

Источник

Проверили, как работает Deep Fusion в новых iPhone

Вчера вечером Apple выпустила обновление iOS 13.2 для iPhone. Главное нововведение — функция Deep Fusion. Если коротко, то это штука, которая улучшает качество фотоснимков. Происходит это благодаря нейромодулю в составе чипа А13 Bionic, с помощью которого система снимает несколько фото с разными значениями экспозиции, проводит попиксельный анализ снимков и затем объединяет лучшие их части в одну крутую фотографию. Как результат — снимки с Deep Fusion отличаются высокой детализацией и фактурностью. Далее будет несколько сравнительных примеров, как снимает iPhone с Deep Fusion и без этой функции.

Для начала отметим, что Deep Fusion работает только на iPhone 11/11 Pro/11 Pro Max. Но и это не все. Дело в том, что Apple никак не обозначает на вашем смартфоне, работает в данный момент функция или нет. Система сама решает, когда надо активировать Deep Fusion, и не ставит пользователя в известность.

Точно известно, что Deep Fusion, как и ночной режим, не работает при съемке с ультраширокоугольной камеры. На основной камере функция активируется при низкой освещенности. А вот на телеобъективе Deep Fusion работает почти всегда, кроме очень яркого освещения, когда задействован Smart HDR.

Источник

Магия Deep Fusion от Apple: Что это на самом деле?

На прошлой неделе Apple выпустили бета-версию iOS 13.2 в которой стала доступна новая революционная технология Deep Fusion, улучшающая фото. Результаты первых тестов получились неоднозначными, вроде бы стало лучше, а вроде бы это совсем чуть-чуть заметно.

Поэтому мы решили разобраться, что это за зверь такой и вообще кому Deep Fusion нужен. Что на самом деле делает эта технология и есть ли в ней смысл?

Как работает?

Начнём с того зачем вообще понадобилась новая технология и что она делает? Если спросить большинство пользователей Apple, они ответят: делает красиво! На самом деле все это работает весьма интересно!

ЭТАП 1

Еще до того как вы нажали на кнопку затвора, в циклическом буфере вращается 8 фотографий: 4 с короткой выдержкой, чтобы заморозить движение и 4 с нормальной.

Плюс ко всему, после нажатия кнопки затвора, делается ещё один снимок, с длинной выдержкой и соответственно яркой экспозицией.

ЭТАП 2

Далее из снимков с короткой выдержкой выбирается наиболее удачный, он становится референтным кадром из которого будут браться контуры и информация о светлых участках. Пока это всё очень напоминает то как делает снимки Pixel со своим HDR+, но вот дальше Apple начинает удивлять.

ЭТАП 3

Дальше, из трех кадров с нормальной выдержкой и одного с длинной каким-то волшебным образом создаётся, так называемый, синтетический длинный снимок. В котором мало шума и есть информация в тенях.

ЭТАП 4

В завершение начинается какое-то вычислительное нейронное пиксельное соитие от Apple: склеиваются референсный и синтетический длинный снимок.

Но самое интересное вот что. Различным участкам этих кадров присваивается один из четырёх уровней детализации. Однотонные области, такие как небо, стены, и прочее — получают наименьший уровень, а, например, кожа, волосы, ткани — наивысший.

Потом оба снимка сливаются воедино, причём необычно: из одного одного снимка берутся только детали, а из другого — цвет, тон и яркость.

Источник

Как работает технология сверхчетких фото Deep Fusion в iPhone 11. Примеры

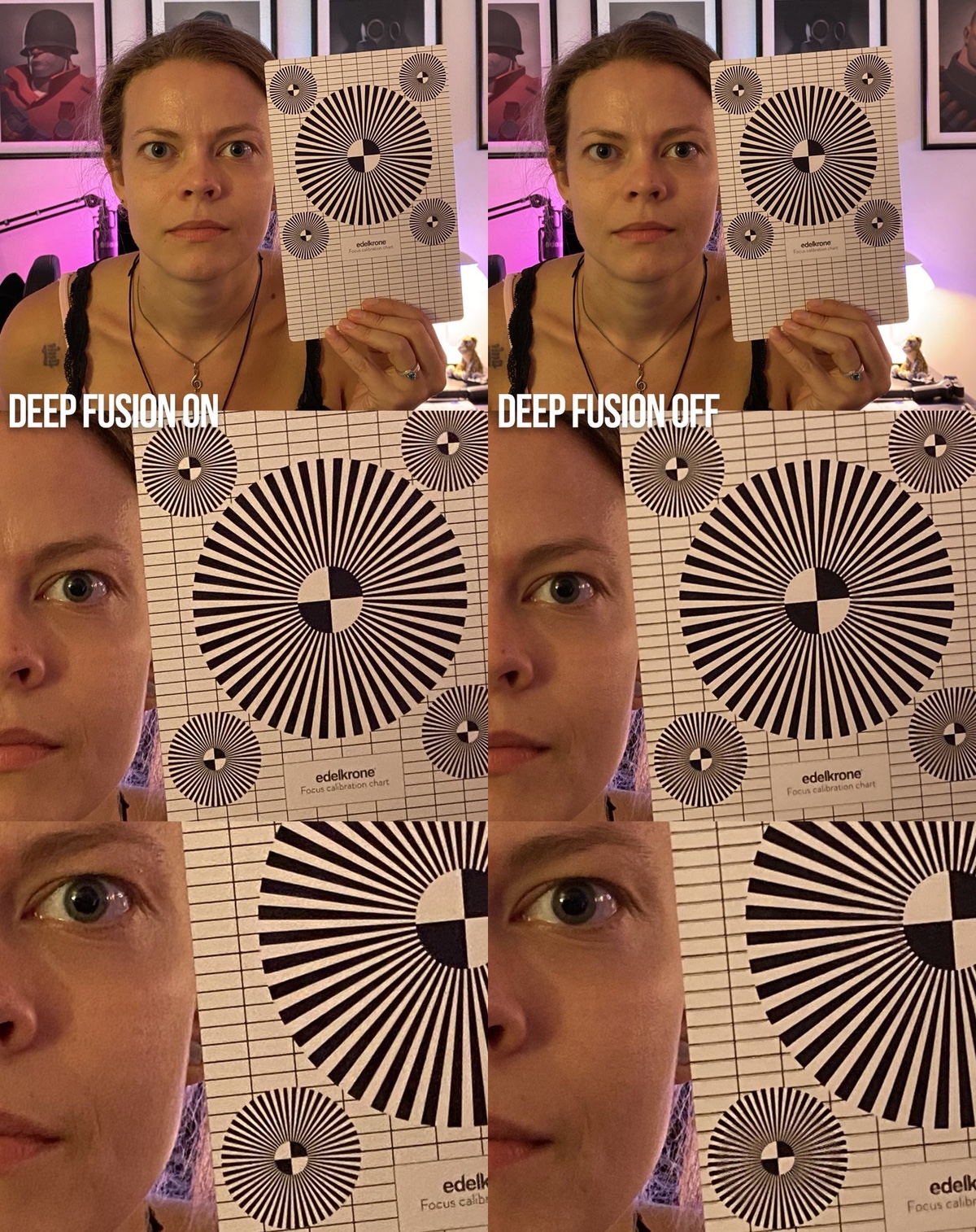

Пользователи уже активно тестируют технологию Deep Fusion для автоматического улучшения фотографий, появившуюся в iOS 13.2 beta 1. Она комбинирует лучшие моменты с нескольких разных снимков в один, обрабатывая их нейросетью и выдавая лучший, наиболее детализированный результат.

В обычном режиме фотографирования вы не заметите, что функция включена. Она работает автономно.

Для работы Deep Fusion необходимо отключить опцию Захват фото вне кадра в меню Настройки -> Основные -> Камера.

Важно: снимки, полученные через эту технологию, прогружаются спустя 2-3 секунды. Если этого не произошло, просто приблизьте фото.

Если вам не нравится результат, добавьте любой эффект в редакторе приложения Фото. Изображение станет мягче.

Примеры фото

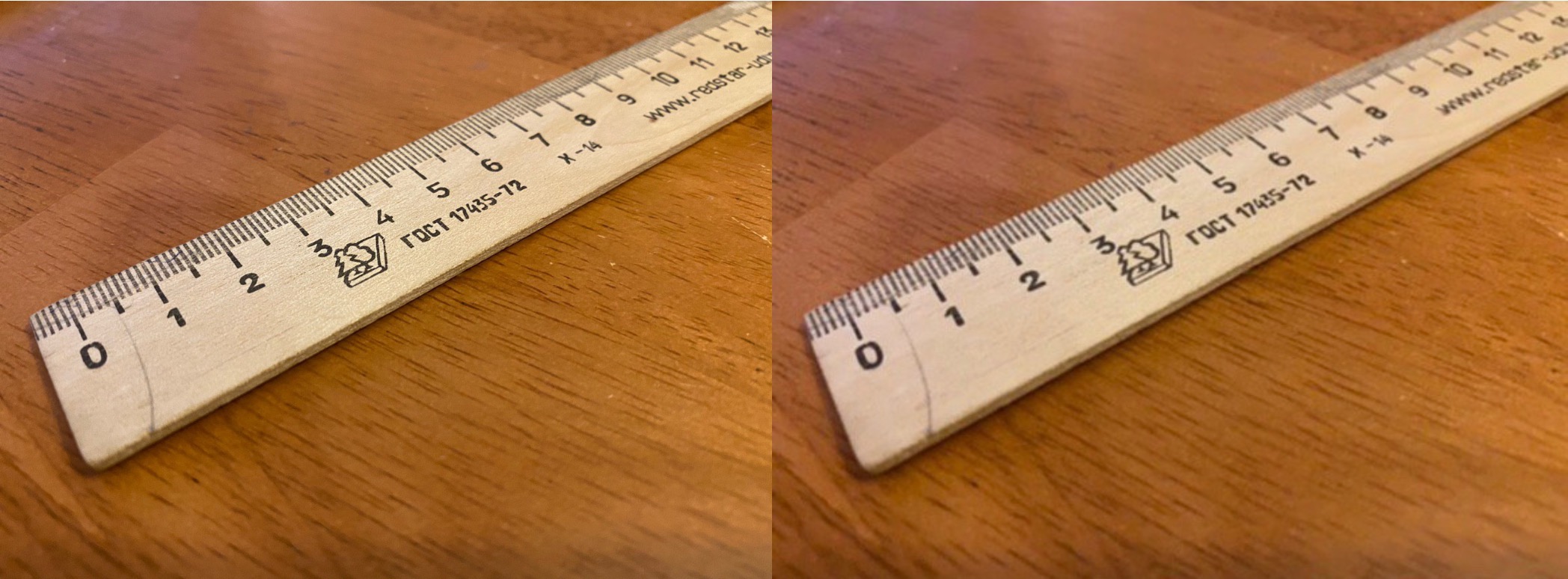

Пример 1. Обратите внимание на надписи на линейке, с включённой технологией они получились очень чёткими, а с выключенной — размытыми.

Слева: Deep Fusion включён, справа: Deep Fusion выключен

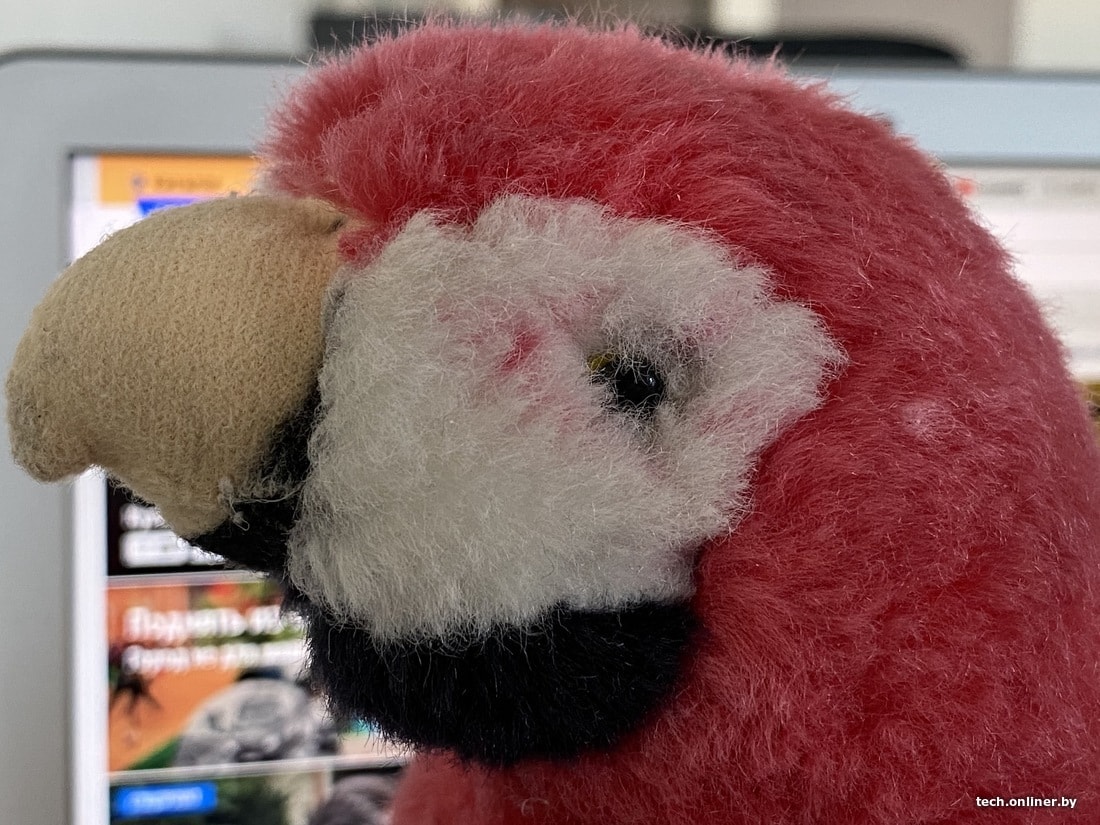

Пример 2. Посмотрите на тумбу повнимательнее. На правой фотографии видно, как единственный на ней волосок хорошо выделяется, а не смешивается со всем фоном. Зелёная отделка стала более детализированной с iOS 13.2.

Слева: Deep Fusion включён, справа: Deep Fusion выключен

А вот снимки, сделанные Себастьяном Де Виттом. На ободе динамика с камеры iPhone 11 с iOS 13.2 видны более четкие текстуры, чем на iPhone 11 Pro с iOS 13.1.2.

Или другое фото с объективом при слабой освещённости. Видно, что надписи на объекте получились чётче, а шумов стало немного меньше.

Снимки сделаны на сверхширокоугольную камеру.

Слева: Deep Fusion включён, справа: Deep Fusion выключен

Слева: Deep Fusion включён, справа: Deep Fusion выключен

Пример от Тайлера Стейльмана. Deep Fusion отлично захватил бороду, лицо и некоторые элементы свитера.

Слева: Deep Fusion выключен, справа: Deep Fusion включен

Слева: Deep Fusion выключен, справа: Deep Fusion включен

Слева: Deep Fusion выключен, справа: Deep Fusion включен

Ниже очередной наглядный снимок от блогера с канала iPhonedo. Обратите внимание на линии.

Слева: Deep Fusion включен, справа: Deep Fusion выключен

А вот блогер с канала Mark’s Tech решил сравнить не фотографии с двух айфонов, а с Samsung Galaxy Note10+ и iPhone 11 с iOS 13.2. И знаете, «самсунг» сделал настоящую кашу, тогда как у айфона получился достаточно чёткий снимок.

Слева: iPhone 11 с Deep Fusion, справа: Samsung Galaxy Note10+

И напоследок. Фото листа кленового дерева от пользователя iMZ. На фотографии с Deep Fusion видны высокая детализация и текстура, тогда как без технологии перед нами размытый лист.

Слева: Deep Fusion включен, справа: Deep Fusion выключен

Что в итоге

Сейчас различия не всегда легко заметить, но уже видно, что технология работает. Фотографии, сделанные с помощью Deep Fusion, получаются более детализированными на обычной, сверхширокоугольной и телефото камерах. При приближении теряется меньше элементов, а шумы на снимках сглаживаются.

Пользователи отмечают, что полученные фотографии с Deep Fusion весят примерно в 2 раза больше, чем во время обычной съёмки. Тот же Стейльман говорит, что фото с iPhone XR занимает 1,4 МБ места, с iPhone 11 — 2,6 МБ.

Это только первая бета-версия iOS 13.2. Со временем Apple может улучшить работу технологии.

Источник

Как включить функцию Deep Fusion из iOS 13.2 на старых iPhone

Для Apple является обычным делом сделать одну функцию доступной для новых iPhone и заблокировать её для других, даже если она не предъявляет особенных требований к аппаратному оснащению смартфонов. Поэтому, когда Apple ограничила работу технологии улучшения фотографий Deep Fusion только iPhone 11, 11 Pro и 11 Pro Max, никто особенно не удивился. В конце концов, нужно же компании хоть какое-то объяснить потребителям, что новинки лучше прошлогодних моделей, и убедить даже тех, кто собирался ещё годик-другой пересидеть на старом смартфоне, в необходимости их покупки. Но какой в этом смысл, если можно, заплатив всего 450 рублей, сэкономить минимум 60 тысяч?

Думаю, не ошибусь, если предположу, что вы никогда не слышали про студию Lux Optics. Но именно она уже который год занимается тем, что проводит за Apple работу над ошибками, исправляя те огрехи, которые компания допустила при оптимизации новых функций для камер фирменных смартфонов. Именно разработчики Lux Optics в своё время адаптировали портретный режим съёмки для iPhone без телефото-объектива, ночной режим и расширили возможности для классической съёмки, позволив вручную настраивать показатели светосилы и выдержки в своём приложении Halide. А теперь они перенесли и режим Deep Fusion на старые модели iPhone.

Что такое Deep Fusion

Deep Fusion – это технология, которая обрабатывает каждый пиксель на фотографии, улучшая его при помощи программных алгоритмов и нейронных сетей. Таким образом удаётся уменьшить количество шумов, повысить детализацию снимка и сделать его более светлым. По сути, это нечто вроде продвинутого режима HDR, за работу которого отвечает искусственный интеллект. Возможно, результат получается не совсем правдивым, учитывая, что такого эффекта удаётся добиться не за счёт оптики, а за счёт инструментов постобработки, которые улучшают кадр на выходе, но кто вообще, кроме профессиональных фотографов, об этом задумается?

В последней версии Halide ( скачать ), которая вышла вместе с iOS 13.2, появился встроенный режим Smartest Processing. Он делает всё то же самое, что и Deep Fusion, за тем лишь исключением, что за обработку фотографий отвечают алгоритмы собственной разработки Lux Optics. Возможно, работают они не так же эффективно, как решение Apple, а потому скорее всего разницу вы всё-таки заметите, но зато постобработка совместима и с iPhone XS, и с iPhone XS Max , и даже с iPhone XR, который с одиночной камерой и процессором A12 исправно вытягивает «умные» улучшения кадра.

Как сделать фотографию лучше

Smartest Processing является не отдельным режимом, а своего рода надстройкой, которая действует по умолчанию в любых режимах съёмки, не подменяя их. Именно поэтому данная функция может улучшать как обычные фотографии, так и портретные снимки, и даже ночные. Это значит, что какой бы режим вы ни выбрали и кого бы ни фотографировали, на выходе ваши фотографии получатся значительно лучше, чем без использования Smart Processing. Но самое главное, что благодаря Halide и Smartest Processing, для этого совершенно не нужно тратиться на новый iPhone, который в России оценивается минимум в 60 тысяч рублей.

Источник