- Apple и NVIDIA — всё? CUDA больше не будет поддерживать macOS

- Поддержка CUDA на macOS

- Почему графики NVIDIA нет на Mac

- Apple отказывается от чипов Nvidia

- Вслед за собственными процессорами у Apple появятся и свои видеокарты

- Графические процессоры будут производиться по техпроцессу 5 нм

- Apple активно работает над собственными видеокартами, но выйдут они лишь через несколько лет

- Почему Apple использует видеокарты AMD а не NVIDIA?

- Почему Apple использует видеокарты AMD а не NVIDIA?

- Почему Apple использует видеокарты AMD а не NVIDIA — полная история:

- Патентные споры до добра не доводят

- Энергоэффективность

- Почему Apple использует видеокарты AMD а не NVIDIA? — вопросы к качеству…

- Реальные отвалы чипов из за перегрева

- Технические моменты

- Прямой доступ к железу

- Вот мнения еще нескольких профессионалов

Apple и NVIDIA — всё? CUDA больше не будет поддерживать macOS

Apple не привыкать ссориться с поставщиками. Известно несколько случаев, когда отношения между компанией и её партнёрами ухудшались настолько, что в Купертино были вынуждены искать альтернативного поставщика или даже начать разрабатывать нужные запчасти или ПО самостоятельно. Иногда это шло Apple на пользу, позволяя ей начать развиваться более активно, как в случае с Apple Maps или собственными процессорами A-серии, которые устанавливаются в мобильные устройства компании и по сей день являются самыми лучшими. Но, к сожалению, чаще всего, как в случаях с Qualcomm или NVIDIA конфликт выходил Apple и — самое главное — её пользователям боком.

Отношения между Apple и NVIDIA можно официально считать завершёнными

Поддержка CUDA на macOS

NVIDIA прекращает поддержку архитектуры CUDA для macOS, начиная с версии 10.2, которая станет последней совместимой сборкой, говорится на сайте компании. Получается, что все будущие релизы CUDA, которые будут выходить после 10.2, не будут совместимы с операционной системой Apple, по сути, лишая изрядную долю профессиональных пользователей, а также пользователей хакинтошей возможности работать с дискретной графикой NVIDIA. Поэтому единственными ускорителями, которые будут актуальны на маках, отныне будут только решения AMD.

CUDA – программно-аппаратная архитектура параллельных вычислений, которая позволяет существенно увеличить вычислительный потенциал ряда функций при условии использования графических процессоров NVIDIA. Благодаря своей эффективности CUDA широко используется в таких областях, как астрофизика, вычислительная биология и химия, моделирование динамики жидкостей, электромагнитных воздействий, компьютерная томография, сейсмоанализ, а также всевозможных графических редакторах и даже играх.

Несмотря на то что для многих ни сам термин CUDA, ни его предназначение до сих пор остаются неизвестными, факт того, что NVIDIA отказывается от поддержки macOS, говорит о многом. Скорее всего, это терминальная стадия негативных отношений между двумя компаниями, восстановить которые будет весьма проблематично. Ведь если скандал с участием Qualcomm был довольно скоротечным и, по сути, строился на стремлении одной стороны продемонстрировать свою силу другой, то в случае с NVIDIA дела обстояли несколько иначе.

Почему графики NVIDIA нет на Mac

Конфликт между Apple и NVIDIA начался ещё десять лет назад, когда Apple лишилась большого количества заказов на MacBook Pro из-за неудачного графического решения. Тогда в Купертино приняли решение, что полагаться на одного поставщика ускорителей, пусть и имеющего отличную репутацию в отрасли, будет нерационально, и обратили внимание на AMD. С тех пор, несмотря на то, что решения последней уступали решениям NVIDIA, отношения между Apple и AMD шли в гору. При этом сама Apple не спешила отказываться от поддержки графики NVIDIA, позволяя владельцам фирменных компьютеров менять один ускоритель на другой по своему желанию.

Читайте также: Скоро мы можем увидеть 14-дюймовый MacBook Pro

Однако то, что произошло теперь, выглядит как настоящий разрыв и прекращение сотрудничества. Как это отразится на Apple, сказать сложно. С одной стороны, в Купертино и так уже давно не используют графику от NVIDIA в своих компьютерах, а значит, обеспечивать их полную работоспособность в компании и не обязаны вовсе. Но, с другой стороны, это может отпугнуть некоторых пользователей — особенно профессиональных, — для которых важна и графика от NVIDIA, и ускоритель CUDA. А если так пойдёт и дальше, Apple рискует потерять часть платёжеспособной аудитории, что для неё очень нежелательно.

Источник

Apple отказывается от чипов Nvidia

Компания Apple может отказаться от использования в своих компьютерах чипов Nvidia на следующие 3-4 года, сообщает SlashGear со ссылкой на SemiAccurate. Заменить графику Nvidia на альтернативные решения планируется одновременно с переводом линеек Apple MacBook и iMac на процессоры Intel с архитектурой Nehalem. Это неокончательное решение Apple, однако, как сообщает источник, переговоры сторон «ведутся на повышенных тонах» и в настоящий момент зашли в тупик. Кто станет новым поставщиком чипов, неизвестно.

Отношения между компаниями были подпорчены низким качеством продукции Nvidia, являющейся крупнейшим в мире поставщиком дискретных графических процессоров. В июле 2008 г. компания объявила о наличии проблемы с некоторыми чипами, установленными в самые различные модели ноутбуков. Из-за некачественного корпуса микросхем системы охлаждения ПК не справлялись с отводом тепла, в результате чипы попросту сгорали. Компания выпустила обновленные драйверы, которые включали вентилятор ноутбука заранее и оттягивали время перегрева.

Проблема коснулась ноутбуков ведущих марок, включая Dell и Hewlett-Packard. Тем временем, как сообщили компании Apple в Nvidia, именно их устройств данная проблема не касается. В действительности это оказалось не так. Вот что написано на веб-сайте Apple в разделе технической поддержки: «В июле прошлого года Nvidia раскрыла информацию о количестве поломок, связанных с ее чипами, превышающим допустимое значение, что связано с некачественной упаковкой процессоров. Нас в Nvidia убедили в том, что в компьютерах Mac этой проблемы нет. Собственное расследование показало, что это не так. Проблема также касается ноутбуков MacBook Pro с процессорами GeForce 8600M GT, выпущенных в период с мая 2007 г. по сентябрь 2008 г.»

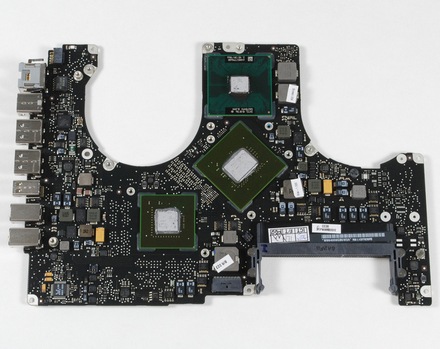

Чтобы заменить один чип Nvidia, приходится менять всю системную плату

Apple объявила о беспрецедентной программе по бесплатному ремонту ПК в течение 3 лет со дня покупки. Притом что стандартная гарантия на компьютеры Mac составляет всего год. Вендор также пообещал компенсацию всем тем, кто произвел ремонт за собственные деньги. Ни для кого не секрет, что подобные программы существенно бьют по карману производителя. Дело было осложнено еще и тем фактом, что заменить чип отдельно нельзя – только системную плату целиком.

По сообщению The Inquirer, отказаться от процессоров Nvidia также думает и Dell. В майской статье сообщалось, что из опций при конфигурировании компьютеров среднего ценового диапазона исчезли видеокарты Nvidia. Издание передает, что Nvidia выплатила Dell $10 млн на ремонт компьютеров, которых оказалось отнюдь недостаточно.

Неизвестно, кто может стать новым поставщиком графических процессоров для Apple. Не исключено, что компания может разработать и собственный чип. Недавно она приняла на работу бывшего главного технического директора подразделения AMD по выпуску графических процессоров Боба Дребина (Bob Drebin). А в прошлом году Apple купила PA Semi, занимающуюся разработкой энергоэффективных чипов.

В заключении стоит упомянуть о судебной тяжбе между Nvidia и Intel, в центре которой договор сторон от 2004 г., разрешающий Nvidia выпускать чипы для процессоров своего партнера. Intel утверждает, что данный договор не затрагивает процессоры со встроенными контроллерами памяти (архитектура Nehalem). Nvidia с этим категорически не согласна. Источник новости, SemiAccurate, не указывает на эту тяжбу прямо. Однако, в первую очередь, намерение отказаться от чипов Nvidia может быть связано именно с нежеланием «яблочной» компании ссориться с Intel.

В прошлом году Apple начала переходить на логику Nvidia, используя ее вместо встроенных графических решений Intel. Данный шаг был обусловлен желанием предложить пользователям более высокую скорость работы.

Источник

Вслед за собственными процессорами у Apple появятся и свои видеокарты

Графические процессоры будут производиться по техпроцессу 5 нм

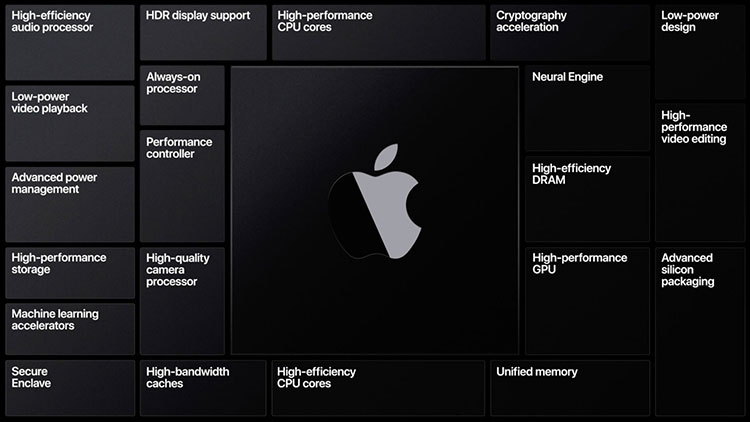

Достаточно авторитетное издание China Times опубликовала заметку, в которой говорится о работе Apple над видеокартами с собственными графическими процессорами. Первый такой GPU проходит под кодовым обозначением Lifuka. 3D-карты на базе Lifuka могут появиться в iMac во второй половине 2021 года.

Рыночные наблюдатели указывают, что Apple прекратила поддержку графических процессоров AMD в 64-битной версии macOS — это говорит о том, что в будущем видеокарты на их базе перестанут использоваться. Им на смену придут видеокарты с графическими процессорами собственной разработки. Ноутбуки Apple с собственными центральными процессорами уже на подходе (первая модель ожидается до конца года), следующий этап — видеокарты с собственными GPU. Они дебютируют в моноблоках iMac во второй половине следующего года.

Издание, ссылаясь на источники, знакомые с ситуацией, уверяет о прогрессе, достигнутом в деле создания собственных GPU. Первый такой проходит под кодовым обозначением Lifuka, а выпускаться он будет TSMC в рамках технологического процесса 5 нм. Само собой, он обеспечит гораздо большую производительность из расчета на ватт энергии, чем нынешние GPU. Он также позволит разработчикам создавать более мощное ПО для редактирования видео.

Источник

Apple активно работает над собственными видеокартами, но выйдут они лишь через несколько лет

Apple во время конференции WWDC 2020 заявила о постепенном переводе в ближайшие 2 года всех компьютеров Mac с чипов Intel x86 на собственные процессоры с архитектурой ARM. Также прозвучали намёки об отказе от графических ускорителей AMD в пользу собственных решений для компьютеров Mac.

Тем не менее, похоже, не стоит ждать скорого появления высококлассных графических ускорителей Apple. Как сообщил информатор Komiya, в ноутбуках MacBook Pro 16 и моноблоках iMac, которые выйдут в 2021 году и будут использовать процессоры Intel, будет задействована дискретная графика AMD Radeon. А вот модели компьютеров на базе новых чипов Apple будут полагаться на довольно мощные интегрированные графические ускорители.

Эту публикацию другой информатор Jioriku дополнил утверждением, что Apple в самом деле активно вкладывается в улучшение своих графических ускорителей, однако вероятнее всего ничего особенно выдающегося (например, видеокарт Apple для настольных компьютеров) мы не увидим ещё несколько лет.

Just to add to this, Apple is working on their graphics processing more and more, but we most like won’t see this come to anything major (like a dedicated GPU for Apple desktops) for a few years https://t.co/Cjnkq4Llei

После этого Komiya добавил, что примерно в конце 2021 или в середине 2022 года Apple откажется в своих Mac от процессоров Intel и видеокарт AMD полностью. Вероятнее всего, её встроенная графика не будет к тому времени мощнее предложений NVIDIA или AMD, но Apple всё равно откажется от сторонних услуг. Также не ранее 2022 года, по данным информатора, могут появиться первые дискретные видеокарты Apple.

In 2022, All models have Apple Silicon and as Jioriku said before, your can select Apple GPUs https://t.co/kBjXZua0Tq pic.twitter.com/8uLWAzm6Nl

Современная однокристальная система Apple A12Z Bionic в тестах OpenCL обходит встроенную графику в чипах AMD Ryzen 5 4500U и Intel Core i7-1065G7. Грядущий в этом году 5-нм чип A14X Bionic для будущих планшетов iPad Pro обещает быть гораздо более мощным — по некоторым оценкам, он будет на одном уровне с 8-ядерным Intel Core i9-9880H. Ходят слухи, что первый 12-дюймовый MacBook на базе ARM, ожидаемый в этом году, получит 12-ядерный процессор — любопытно будет увидеть, какую производительность сможет предложить такая система.

Источник

Почему Apple использует видеокарты AMD а не NVIDIA?

Почему Apple использует видеокарты AMD а не NVIDIA?

Почему Apple использует видеокарты AMD а не NVIDIA? Есть множество компетентных мнений на эту тему. Ведь Apple — это огромная компания. Сложилось предвзятое мнение, что Nvidia лидирует в рынке. А вот так ли это? Давайте посмотрим.

Почему Apple решила использовать графику AMD вместо Nvidia. Но, во-первых, есть причины, по которым Apple смогла отказаться от Nvidia.

В пространстве “x86” есть два основных GPU-игрока: AMD и Nvidia. В течение многих лет (и в то время этот вопрос был первоначально задан) NVidia имела “превосходящую” архитектуру для производительности на ватт на настольных ПК.

Nvidia, когда дело дошло до Apple, не имела столько преимуществ же, как на десктопной арене. И у них к тому же хуже поддержка OpenCL, чем у AMD. Их энерго-эффективность почти полностью исчезает в силу требований Apple к управлению энергией. И что еще хуже для Nvidia, AMD продемонстрировала большую готовность и способность работать с другими компаниями. Отличный пример этого-оригинальный 5K iMac, которому потребовались некоторые доработки видеокарты, чтобы экран работал на 60 Гц.

Есть еще так же некоторые” юридические » причины, которые заставили Apple полностью отказаться от Nvidia:

Если кратко: Nvidia попыталась лицензировать свою графическую архитектуру и патенты на мобильные компоненты. Все, к кому они обращались, не хотели «своей» архитектуры и не верили, что патенты нужны. Apple была среди этих компаний и не очень хорошо приняла этот шаг от NVidia. И NVIDIA с тех пор нет на устройствах Apple.

Почему Apple использует видеокарты AMD а не NVIDIA — полная история:

в 2013 году Nvidia официально начала продвигать программу лицензирования для своей архитектуры. И ряд патентов на мобильные GPU. NVIDIA лицензия Кеплер и будущие GPU IP для 3-х сторон

Nvidia полагала, что у них есть патенты, которые они предъявили Qualcomm и Samsung, применяемые к большинству архитектур мобильных GPU. Но об этом будет немного позже. Во всяком случае, NVidia подкатила к Apple, Qualcomm, Samsung и, вероятно, нескольким другим компаниям. Предлагая им лицензию, где цена была весело завышена, и все они отказались.

Затем Nvidia либо снова попыталась протолкнуть вопрос о патенте в Apple, либо угрожала им юридически. Или когда были поданы иски против Qualcomm и Samsung, или, может быть, Apple просто почувствовала, что даже первый разговор об этом ни к чему хорошему не приведет. Точный момент, когда это было решено, на самом деле не имеет значения. Важно то, что Apple не захотела впредь иметь дело с Nvidia. Тем более когда у них был другой партнер, который был так же хорош, если не лучше.

Патентные споры до добра не доводят

Теперь, немного раньше, или, может быть, немного позже, были поданы иски NVidia против Qualcomm и Samsung. Поданные NVIDIA патентные претензии против Qualcomm и Samsung в этих судебных процессах были такие же, которые NVidia планировала подать и против Apple. Nvidia хотела типо предотвратить Samsung от продажи телефонов с использованием контрафактных компонентов. Должно быть ясно, почему Apple не приняла условия лицензирования Nvidia положительно. Или они просто стали задумываться об этом и какие последствия могут быть.

В дальнейшем NVIDIA и Samsung урегулируют все споры о нарушении патентов, но, в основном, патенты не были нарушены. Все вроде решилось. Но Apple приняла скрытую угрозу к сведению.

Почему Apple использует видеокарты AMD а не NVIDIA? Ведь все потому, что Nvidia пыталась заставить Apple согласиться на их фиктивную схему лицензирования Kepler. И даже не думая Apple сказала «нет». Nvidia пригрозила судебным иском, а Apple ответила «Нет, До свидания». Вот так просто…

Примечание: для ясности, почему это действие (а не то же самое от Samsung, Qualcomm и т. д.) подтолкнуло Apple к тому, что Nvidia просит более 1% ASP на единицу. При текущих продажах это будет в диапазоне 1,5-2 миллиарда долларов в год.

Nvidia была достаточно умна, чтобы не напасть на Apple официально. И открыто подать в суд на свои патенты (как они сделали с Samsung, и как я считаю Qualcomm), не выиграв дело. Так что это не стало достоянием общественности.

Энергоэффективность

Кроме того, AMD имеет больше поддержки и лучшие драйверы для OpenCL. И мне кажется, гораздо более готовы работать с другими компаниями.

И при низких тактовых частотах, как Apple как правило изапускает карты AMD, их производительность на ватт близка к равной по сравнению с Nvidia. Apple больше заботится о производительности при x ваттах мощности. А не о пиковой производительности.

Например, при 35 Вт графические процессоры Radeon Pro, используемые в ноутбуках Macbook Pro, примерно равны 35 Вт от NVIDIA. При таком подходе разницы практически нет какой чип использовать.

Почему Apple использует видеокарты AMD а не NVIDIA? — вопросы к качеству…

Интересно, почему это еще не упоминалось, но раньше вы могли легко увидеть чипы nvidia в продуктах apple.

Несколько лет назад, около 2008-2009 годов, nvidia продавала чипы, у которых был критический недостаток, когда gpu в основном отделялся от пакета/подложки. Позже он был придуман как “bumpgate”.

В принципе, nvidia изменила материал, используемый для подключения матрицы gpu и подложки, который имел лучшие свойства в целом. Но при этом имел недостаток в низкой проводимости. Что означает, что вам нужно таких их для обеспечения адекватной мощности чипа. Nvidia не заметила этого, а это означает, что эти соединения, называемые шишки, имели тенденцию расширяться больше, чем ожидалось под нагрузкой, из-за перегрева. Это, очевидно, не очень хорошо само по себе, но nvidia также использовала очень жесткую подложку под своими чипами. Подложку, у которой не было соответствующей деформации, чтобы впитать это расширение bump. Это означало, что эти критические соединения имели тенденцию просто разрываться пополам, разрывая электрические соединения.

Реальные отвалы чипов из за перегрева

Все это означало, что частота отказов этих графических процессоров может достигать 40%. Эта проблема затронула все чипы nvidia 65nm и 55nm (все карты архитектуры tesla), но это было особенно плохо в высокотемпературных средах. Именно таких как, вы догадались имеют ноутбуки! Ведь с охлаждением там реальный дефицит.

Это так же затронуло MacBook Pro той эпохи. В Apple были буквально ошеломлены высокими коэффициентами отказов из-за графического чипа, буквально отваливающегося от платы.

Apple, очевидно, и так не была очень счастлива. Но это еще усугубилось, когда nvidia подала в суд на apple, dell, hp и т. д., обвиняя их в высоких коэффициентах сбоев.

Это, идет в довесок к тому, что уже было сказано, почему apple больше не использует чипы Nvidia. С тех пор у Apple и Nvidia были ужасные деловые отношения.

Технические моменты

Вот что еще приходит на ум, когда вы думаете “почему Apple использует графику AMD, а не NVIDIA”:

Обзор ArsTechnica объясняет, почему Apple пришлось использовать графические процессоры AMD в 15 » MacBook Pro

“…Это также причина, по которой Apple не могла выбрать более быстрые графические процессоры Nvidia, — говорит Ars.

Энергопотребление мобильного чипа GTX 1060, самого медленного чипа ноутбука Nvidia на базе Pascal, имеет TDP 85 Вт. Тогда как все графические процессоры AMD в MacBook Pro требуют 35 Вт. так же карты Nvidia поддерживают максимум четыре дисплея. И хотя графические процессоры Nvidia поддерживают DisplayPort 1.3, контроллер Thunderbolt 3 и большинство мониторов поддерживают только 1.2.

Это поднимает вопрос о том, может ли Apple предложить вариант с Nvidia. Прям сразу, как только DisplayPort 1.3 будет более широко распространен. Nvidia ГПУ могут управлять внутренним дисплеем плюс до трех мониторов 5K. Ведь четыре потока отображения у графического процессора это не шутка…

Почему Apple использует видеокарты AMD а не NVIDIA? Карты NVIDIA, как правило, потребляют больше энергии, чем AMD видеокарты. И кроме того AMD больше идет на встречу при работе с партнерами.

Прямой доступ к железу

Кроме того Apple имеет собственные алгоритмы для оптимизации вывода графики. Для выполнения которой необходим обойти блокировки драйверов NVIDIA и непосредственно взаимодействовать с аппаратурой. И следовательно, требуют более прямое воздействие с NVIDIA чипами. (по сравнению с другим программным обеспечением, которое работает на драйверах Nvidia, а не в обход его). Что разумеется против внутренней политики NVIDIA при реализации решений для клиента.

Я не являюсь юридическим экспертом, и я понятия не имею, сколько экспозиции обычно считается приемлемым у Nvidia. Но алгоритмы оптимизации Apple требовали уровня больше, чем тот который был. И поэтому Nvidia и Apple должны были расстаться после Maxwell. Можно сказать это еще одна причина.

Я думаю что это только верхушка айсберга, и причин может быть еще целое множество.

Вот мнения еще нескольких профессионалов

1. Почему Apple использует видеокарты AMD а не NVIDIA? MacBook особенно MacBook Pro ориентирован на профессионалов, так что это также удивительно для меня. Я про отсутствие Nvidia на девайсах Apple. Но дело в том, что графические процессоры AMD гораздо более энергоэффективны, чем графические процессоры Nvidia. И в соответствии с ArsTechnica и другим сайтом tech news, Apple пришлось использовать графические процессоры AMD с последним обновлением линейки MacBook 15, потому что это был единственный способ позволить их машине управлять двумя мониторами 5K.

Используя графику Intel Iris в 13-дюймовой модели и AMD Radeon Pro в 15-дюймовых моделях, Apple получила хороший результат: 13-дюймовые модели поддерживают один 5K дисплей, 15-дюймовые модели два.

2. Почему Apple использует видеокарты AMD а не NVIDIA? Поскольку стандартизация на графических процессорах одного поставщика значительно упрощает обслуживание API-интерфейсов графики Metal (и теперь Metal 2). Было широко известным секретом, что Metal на OS X Sierra не давал идентичных результатов на Mac. Это с графическими процессорами Intel, AMD и Nvidia. Частенько приходилось посражаться, чтобы написать игру, которая работала хорошо и была эффективна на всех 3.

Выбор AMD, потому что очевидно, когда выяснилось, что Intel будет включать AMD GPU внутри некоторых из их будущих процессоров. (Эта сделка была объявлена, но проскальзывала и ранее в отрасли за 3 или 4 года до этого).

3. Почему Apple использует видеокарты AMD а не NVIDIA? Apple использовала видеокарты nVidia в предыдущих моделях Mac еще в 2013 году. А MacBook Pro предлагал GT 750M. Apple, вероятно, переключается между поставщиками GPU. На основе того, кто дает им более выгодную сделку и на основе того, что лучше подходит для конкретного продукта. В то время Mac Pro был недавно обновлен Apple, вероятно, получил более низкую цену от AMD для карт FirePro. Чем они могли бы получить от nVidia для карт Quadro.

Текущее поколение графических карт nVidia доступно только в форм-факторах рабочего стола. Это было ко времени выпуска очередной партии Apple. (ноутбуки, использующие GTX 1060/1070/1080, просто используют десктопные чипы). Apple, вероятно, не хочет тспользовать 1050 или использовать карты предыдущего поколения. Apple, вероятно, должна предлагать карты nVidia на iMac, хотя, особенно в качестве BTO на 27″. Поскольку он, вероятно, может легко разместить 1080. Что намного быстрее, чем Radeon Pro 580.

4. Почему Apple использует видеокарты AMD а не NVIDIA? Ценовой диапазон в основном. И, возможно, лучшие общие отношения между фирмами. AMD физически производила процессоры для Apple до ухода Стива Джобса. Кроме того, они были частью программы PowerPC вместе с Apple и IBM, я думаю. Да, эти компьютеры, сделанные apple, но также такие вещи, как Nintendo GameCube и Will. И возможно, даже xboxes или PlayStation.

Я собрал тут достаточно информации, чтобы побольше раскрыть этот вопрос. Но если что и упустил — не стесняйтесь добавить это в комментариях ниже.

Источник